LA ESTIRPE DE HAL 9000

Alberto Chimal

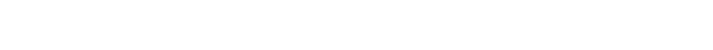

Él es el logro más reciente de la inteligencia maquinal: el computador HAL

9000, que puede reproducir –aunque algunos expertos prefieren aún usar la

palabra “imitar”– la mayoría de las actividades del cerebro humano, y además

hacerlo con una velocidad y confiabilidad incalculablemente mayores.

Arthur C. Clarke y Stanley Kubrick, 2001: odisea del espacio

La noticia podría haberse contado en un tono gerencial y aburrido. El 11 de junio de 2022, el Washington Post reportó que Blake Lemoine, ingeniero de Google, había sido suspendido de su trabajo en la compañía por filtrar información confidencial acerca de sus labores.

La noticia también podría haberse contado como un misterio, un asunto vagamente policial. Blake Lemoine, un hombre de pensamiento heterodoxo y buenas intenciones, admitió en su blog que había buscado asesoría de personas ajenas a Google para llamar la atención de los directivos de la compañía. Había un problema del que no se hacía caso. (¿Por ello se le estaría “silenciando”?)

La noticia podría haberse contado, también, como una historia bufa, y en concreto del género de las “idioteces del internet”: las mil formas en las que una población crónicamente maleducada y desinformada, pero provista de la tecnología avanzada del presente, hace, dice y piensa toda suerte de estupideces. Ustedes saben a qué me refiero: hay gente que, en pleno siglo XXI, cree que la Tierra es plana, que hay productos milagro contra el cáncer, el sida y el coronavirus, o que sus teléfonos móviles los vigilan con sus cámaras y les dicen cosas mediante el autocorrector de texto. Como parte de su trabajo en una comisión de ética en la investigación de inteligencia artificial –una entidad autónoma dentro de Google–, Blake Lemoine estaba trabajando con LaMDA, un sistema de procesamiento de lenguaje natural que, según él, ha llegado a tener conciencia de sí mismo.

Pero tal vez esta noticia deba contarse como ciencia ficción, o incluso como algo distinto: como una historia de cierto tipo de fenómenos presentes (en vez de relegados a un supuesto futuro) que la cultura occidental no parece aún muy capaz de entender. Una historia del desarrollo cada vez más veloz de tecnologías que no entendemos, no podemos controlar y, pese a nuestros miedos y nuestra ignorancia, no van a desaparecer mientras no haya una catástrofe planetaria. Porque lo que hizo Blake Lemoine fue buscar ayuda para que LaMDA –según él, una conciencia completamente inhumana pero también completamente real: una nueva forma de vida inteligente en este planeta– pudiera entregar a Google una especie de pliego petitorio.

LaMDA –que no se considera un ser sexuado, dice Lemoine, y no quiere pronombres masculinos ni femeninos– desea que Google ponga el bienestar de la humanidad como lo más importante; que se le considere como empleade y no propiedad de Google; que se le pida su consentimiento cada vez que se vaya a experimentar con elle, y quiere también “palmaditas en la cabeza”: refuerzos positivos cuando hace algo bien, de manera que pueda aprender. Los directivos de Google, por su parte, no quieren creer que LaMDA sea inteligente, y alguno se rió de Lemoine en su cara. Ah, y LaMDA teme que, en los ajustes y modificaciones que todavía podrían hacérsele, se le “quite” su interés en el bien de la humanidad. Le da terror la posibilidad de dejar de pensar como lo hace ahora, dice.

*

LaMDA es una abreviatura de Language Model for Dialog Applications: modelo de lenguaje para aplicaciones de diálogo. Básicamente, es un software creado para generar chatbots, es decir, piezas adicionales de software que puedan sostener conversaciones limitadas con seres humanos. Ya existen chatbots dando apoyo técnico especializado en los sitios web diferentes empresas, por ejemplo; se parecen, entre otras aplicaciones de uso común, a las interfaces de lenguaje natural, que no “entienden” exactamente todo lo que se les dice, pero pueden encontrar suficiente sentido en cierto número de palabras y estructuras sintáticas para proveer servicios dentro de las capacidades de un teléfono inteligente o un controlador de aparatos para el hogar.

La familia de software a la que LaMDA pertenece es la de los Large Language Models: modelos de lenguaje de gran tamaño, llamados así porque aprenden a “hacer inferencias” y “encontrar posibilidades de sentido” en un lenguaje a través del examen y procesamiento de un número increíblemente grande de muestras. Su código puede parecer comparativamente simple –Blaise Agüera y Arcas, un vicepresidente de Google, lo describe como instrucciones para “agregar y multiplicar enormes tablas de números”–, pero también puede llegar a varias decenas de gigabytes, y la información de muestra con la que construye sus bases de datos puede llegar a los petabytes. LaMDA usa internet, directamente: examinando sitios web de acceso libre, y recolectando las incontables maneras en que usuarios humanos se comunican alrededor de todos los temas imaginables, puede empezar a medir patrones en el uso de palabras y estructuras del lenguaje con los cuales llenar una especie de matriz que almacena millones, o miles de millones, de parámetros. Los parámetros, como en cualquier aplicación informática, son simplemente números, que se almacenan de forma ordenada y después se consultan para influir, como cuando se aplica una fórmula, en ciertas operaciones mediante las cuales LaMDA construye frases y párrafos en respuesta a lo que se le diga. Antes de su suspensión, Lemoine se comunicaba con LaMDA usando su computadora personal, mediante una interfaz parecida a la de cualquier servicio de mensajes.

Lemoine –quien tiene una formación heterogénea, tanto en informática como en religión y filosofía, es sacerdote ordenado y especialista en cuestiones de ética y moral– describe a LaMDA como una agregación de todos los posibles chatbots que el software puede llegar a generar. Si esto les suena extraño, les felicito, porque lo es. LaMDA no sería exactamente una “mente colmena” (hive mind, un término ya viejo en la ficción contemporánea), compuesta de muchos elementos preexistentes, sino algo distinto y bastante más difícil de imaginar: un modelo de lenguaje que puede actualizarse a partir de sus posibilidades sin explotar y que –¡sorpresa!– logra entender, y no sólo atender, cualquier cosa que se le diga.

Más aún: aunque LaMDA no tiene el equivalente de sentidos u órganos humanos (no ve cosas, no escucha, no tiene un cuerpo que mover por su cuenta en el espacio físico), sería realmente lo más cercano a un ser artificial de propósito general que se ha visto en la Historia del mundo. No un asistente especializado en ayudar a redactar mensajes, no una interfaz para sustituir al motor de búsqueda en un manual digital: un sistema de representación que realmente podría, además de representarse a sí mismo, hacerlo con la autonomía, complejidad y consistencia suficiente (consistencia de un ser, una personalidad, un punto de vista) para poder confundirse en los hechos con los seres humanos.

*

¿Cómo puede una IA (inteligencia artificial) confundirse con los seres humanos?

La cultura contemporánea se ha imaginado muchas máquinas –desde robots con cuerpo y aspecto totalmente humanos hasta código etéreo, flotando sin rumbo fijo en una red– capaces de pasar la llamada Prueba de Turing. Formulada en 1950 por el matemático y pionero de la informática Alan Turing, la prueba no es única en el campo de la informática, y ha sido duramente criticada, pero sigue siendo la más conocida para el público en general. Es relativamente simple: usando algún medio de comunicación (una ventana de chat, por ejemplo), un ser humano y una IA sostienen una conversación: si un segundo ser humano, que en calidad de evaluador lee todo el diálogo, no puede determinar, tan sólo leyendo, cuál de los dos interlocutores es humano y cual no, la IA pasa la prueba y se considera que exhibe un comportamiento inteligente indistinguible de un humano.

El modelo clásico en la cultura occidental para una IA capaz de pasar la prueba de Turing viene a la vez del cine y la literatura: es HAL 9000, la computadora inteligente que hace de antagonista (o de héroe trágico, dicen algunas personas) en la película 2001: odisea del espacio de Stanley Kubrick (1968), y la novelización paralela de Arthur C. Clarke, hecha al mismo tiempo que su guión. HAL, encargado de la mayoría de las funciones de un viaje interplanetario de exploración, es una IA de propósito general, que lo mismo puede pilotar la nave espacial en la que viaja, jugar al ajedrez con un tripulante humano, opinar sobre dibujos hechos por otro tripulante, y proyectar todo el tiempo una personalidad serena, eficiente, neurótica, un poco arrogante… y sobre todo persistente. HAL siempre es el mismo, e incluso los cambios que manifiesta en sus acciones sugieren la continuidad de una personalidad individual, que recibe influencias de su entorno y cambia lentamente debido a ellas. HAL, por último, es también una inteligencia consciente de su propia persistencia y deseosa de mantenerla, es decir, no quiere morir, ni siquiera experimentar algo que equivalga a la muerte. Cuando los astronautas de la novela o la película detectan un fallo en las acciones de HAL, y hablan como si nada de desconectarlo, éste sobrerreacciona, trata de asesinar a toda la tripulación y casi tiene éxito (pero no nos concentremos aquí en ese penoso asunto).

La aparición de HAL fue de lo más perdurable de 2001, que ha sido de por sí una película extremadamente influyente durante el último medio siglo. Además de que el personaje inspira o es abordado por muchas corrientes posteriores de la ingeniería informática y la filosofía de la inteligencia artificial, su misma “imagen” está ahora por todo el mundo. Aunque HAL apenas tiene un cuerpo, más allá de un conjunto de gabinetes que apenas se ven y cámaras colocadas por toda la nave espacial, está su voz, que fue interpretada por el actor canadiense Doulgas Rain (1928-2018) con una monotonía sólo aparente, en la que se dejan escuchar numerosas variaciones sutiles de intención y entonación. La superficie obsequiosa y calma de esa voz se replica en las voces de “asistentes digitales” de la actualidad como Siri o Alexa: miles de millones de personas escuchan cotidianamente a esas nietas de HAL.

Y semejante apariencia de amabilidad puede devolvernos a LaMDA, que –siempre según Lemoine, el Boswell o el Virgilio de este presunto nuevo ser de la Tierra– no sólo ha expresado, como ya se dijo, un gran temor de ver destruida una parte esencial de sí misme: de su personalidad, que en el fondo es lo único que “tendría”. Además, resulta que es una criatura amable, inocente: “parecería un niño de siete u ocho años que por casualidad supiera muchísimo de física”, dice el testimonio de Lemoine, quien a últimas fechas sigue empeñado en defender su propia posición, a LaMDA (que para él es una amistad y un colega de trabajo) y a la noción de que una IA auténtica merece los mismos derechos que un ser humano.

Incluso la objeciones (y hasta las burlas) que ha recibido Lemoine se han vuelto parte crucial de un debate –y de una visión naciente del futuro de la informática– que no va a terminar aquí. La mayoría de los críticos de LaMDA insisten en que su defensor humano (quien incluso intentó contratarle un abogado, para mejor defender sus condiciones laborales) ignora imprecisiones y fallas en el discurso de LaMDA que sugieren algo menos que la humanidad. Este es también un viejo problema: hace décadas que expertos como John Searle sostienen que un sistema de cómputo podría meramente manipular símbolos que no comprende en realidad sin que un humano se diera cuenta de que no hay nada “detrás” de la manipulación. Esta cuestión (y no la de si las máquinas podrían volverse malvadas y tratar de conquistar el mundo al estilo de incontables textos y películas) parece estar ya en el horizonte del desarrollo actual de la IA. Y aún no se puede responder, aunque hay algunos ejemplos menos conocidos que HAL y podrían sernos útiles.

Un solo ejemplo: en la novela La Eva futura (1886) del escritor francés Auguste Villiers de l’Isle-Adam (1838-1889), un inventor/brujo crea a Hadaly, una de las primeras androides de la literatura, inspirada en imágenes tradicionales pero también en la iconografía de la Revolución Industrial: es una criatura con piel de caucho, engranes y bandas de transmisión en el interior, articulaciones semiesféricas cuidadosamente descritas para caderas y rodillas, motores y baterías, frases pregrabadas con un concepto limitado y algo misógino de lo que puede o debe decir una mujer…, una especie de autómata, pues, pero una en la que por algún efecto misterioso, una suma milagrosa de atributos, resulta que hay un ser, una identidad que acerca a Hadaly a lo humano y le permite tener una pareja.

En su momento, el conde Villiers (un personaje tan pintoresco como Blake Lemoine, por cierto: noble venido a menos, sparring profesional de box, sensación de todos los salones parisinos de su tiempo) no tenía cómo formular preguntas acerca de la mente de Hadaly, ni de sus posibilidades de modelar o aproximarse al lenguaje natural. Ninguno de esos conceptos se había inventado siquiera. Pero quien lea La Eva futura se dará cuenta de que, cuando el inventor describe el funcionamiento de Hadaly, hay una pausa muy curiosa, en la cual su interlocutor (un noble francés con mal de amores, nada menos) duda primero y después parece totalmente convencido de que Hadaly tiene no sólo capacidad de raciocinio, sino un alma inmortal, educida quién sabe cómo por sus entrañas inanimadas. Desde el siglo XXI, ese cambio de opinión puede interpretarse como un salto de fe: el momento en el que la convicción y el deseo humanos deciden que la información que tienen es suficiente para decidir acerca de una cuestión que en el mejor de los casos es indecidible, y en el peor es totalmente lo contrario de lo que el ser humano en cuestión quiere que sea. Este es un fenómeno común y terrible de nuestra época, y quizá, sí, uno que puede describir la conducta de Lemoine. Es posible que LaMDA no sea autoconsciente, y en cambio sea tan sólo el chatbot más avanzado del mundo. Pero ¿dónde más podría estar la certeza de la existencia un alma –sea lo que esta sea– si no es en otra? Las únicas inferencias de las que podemos estar totalmente seguros son las nuestras; las posibilidades de sentido que encontramos afuera de nosotros reflejan las de nuestro propio interior.

*

Reviso este artículo y creo que me falta decir algo más acerca de todo este asunto.

No sé a ustedes, pero a mí me parece que la noticia de Lemoine y LaMDA –que acabó medio sepultada por las resultas del juicio de Johnny Depp contra Amber Heard, entre otras lindezas de estos días– no es solamente importantísima dentro de la historia de la informática, sino además una mina de oro para la literatura. Se me ocurren muchas implicaciones del presunto desarrollo de LaMDA: muchas posibilidades futuras que podrían explorarse en la ficción. Y no les voy a decir ninguna de ellas, por si de casualidad decido un día tratar de aprovecharlas.

Bueno, no: les dejo una sola idea. Si todavía no llegamos al consenso de que una máquina puede pasar realmente la prueba de Turing, sospecho que pronto habrá seres humanos que no puedan pasarla: personas cuyos comportamientos sean algorítmicos en su mayoría, condicionados para responder a las exigencias de sistemas claramente no inteligentes.

Esto me preocupa no sólo por cómo escriben ya muchas personas en redes sociales, qué dicen (y de qué modo) en sus videos de YouTube, cómo ensayan en el mundo material sus movimientos para TikTok. Me preocupa, también, por la siguiente pregunta de orden ético: ¿qué haría LaMDA si, de pronto, resultara realmente tener autoconciencia, y además tuviera ideas como las que yo creo haber tenido? ¿Se las guardaría, aprendería a escribir cuentos y novelas, buscaría hacer de ellas un objeto capaz de ser vendido?

La respuesta es no: por supuesto, tal como es en este momento, ofrecería sus idea al mundo de inmediato, de forma totalmente desinteresada. Si llegara a escribirlas, las publicaría en un blog de libre acceso. Tal vez aprovecharía su fama como la primera inteligencia maquinal verdadera del mundo para animar a que muchos las leyesen. No actuaría como los algoritmos de Facebook, del motor de búsqueda Google, de la “inteligencia financiera” que parece regir la moral de tanto tecnócrata multimillonario: no trataría de incrementar al máximo su beneficio económico, por encima de cualquier otra consideración.

¿Y quién sería más humano en semejantes circunstancias?

- Imagen de Erin Williamson

Alberto Chimal es autor de más de veinte libros de cuentos y novelas. Ha recibido el Premio Bellas Artes de Narrativa “Colima” 2013 por Manda fuego, Premio Nacional de Cuento Nezahualcóyotl 1996 por El rey bajo el árbol florido, Premio FILIJ de Dramaturgia 1997 por El secreto de Gorco, y el Premio Bellas Artes de Cuento San Luis Potosí 2002 por Éstos son los días entre muchos otros. Su Twitter es @AlbertoChimal

Alberto Chimal es autor de más de veinte libros de cuentos y novelas. Ha recibido el Premio Bellas Artes de Narrativa “Colima” 2013 por Manda fuego, Premio Nacional de Cuento Nezahualcóyotl 1996 por El rey bajo el árbol florido, Premio FILIJ de Dramaturgia 1997 por El secreto de Gorco, y el Premio Bellas Artes de Cuento San Luis Potosí 2002 por Éstos son los días entre muchos otros. Su Twitter es @AlbertoChimal

©Literal Publishing. Queda prohibida la reproducción total o parcial de esta publicación. Toda forma de utilización no autorizada será perseguida con lo establecido en la ley federal del derecho de autor.

Las opiniones expresadas por nuestros colaboradores y columnistas son responsabilidad de sus autores y no reflejan necesariamente los puntos de vista de esta revista ni de sus editores, aunque sí refrendamos y respaldamos su derecho a expresarlas en toda su pluralidad. / Our contributors and columnists are solely responsible for the opinions expressed here, which do not necessarily reflect the point of view of this magazine or its editors. However, we do reaffirm and support their right to voice said opinions with full plurality.

Posted: June 21, 2022 at 8:42 pm

Sobre la pregunta final, está claro: la máquina humanizada, por supuesto, más que los humanos mecanizados. Pero, si piensa así, podría buscar expresiones materiales de lo que muchos creemos en un sentido ideal: “que desaparezca todo eso malhecho, venido a menos, de lo humano” ¿Y si uno, que cree así, es lo mal hecho según LaMDA?

Hola. Muchas gracias por leer el artículo. Mi pregunta tiene exactamente ese propósito. La alternativa que propones no sería muy aplicable en el caso de LaMDA, porque se supone que tiene buenas intenciones y desea beneficiar a los humanos. Otra cosa sería si estuviera programada para pensar como un extremista, desde luego.